事前準備

このチュートリアルでは、事前に以下のコマンドを使用してパッケージをインストールしてください。.envファイルに保存してください。

.env

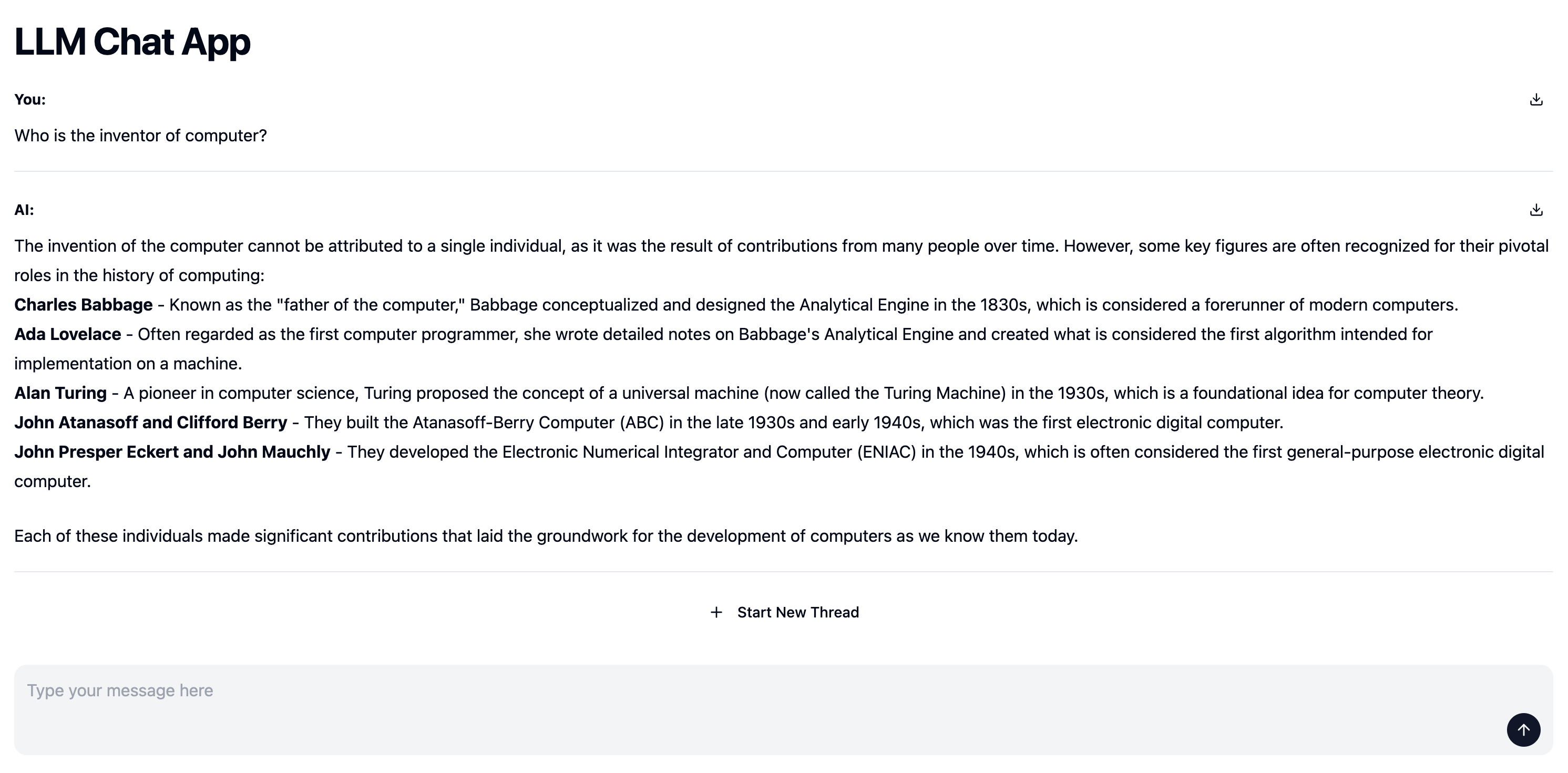

最終的な成果物

チュートリアル

<Chat />コンポーネントを使用して、LLMのAPIを活用したチャットアプリを作成します。

Python関数でLLMを用いたチャットアプリのロジックを実装し、yieldを使用して、チャットのログをストリームで返することで、自動的に<Chat />がストリーミングの結果を表示します。

- 1. Python

- 2. MDX(pages)

OpenAIのSDKを使用して、ユーザーからの質問に回答するロジックを実装します。

<Chat />コンポーネントのpostData属性に指定された関数はpromptとthread_idを引数として受け取ります。- prompt: ユーザーから入力されたプロンプト

- thread_id: チャットスレッドのID。新しいスレッドが開かれると新しいIDが発行されます。